L'extraction d'information ouverte

Introduction

Un des grands enjeux de l’intelligence artificielle (IA) est de permettre l'extraction des connaissances structurées à partir de textes libres, comme celui que vous lisez en ce moment, construit de phrases complexes et de plusieurs paragraphes. Les néophytes en IA seront peut-être surpris de savoir que ce n’est pas encore le cas : pour le moment, il reste ardu pour des systèmes informatiques d’extirper seuls des connaissances à partir de discours en langue naturelle. Lorsqu’ils y arrivent, c’est parce qu’ils sont guidés par un ensemble de relations-cibles apprises à l’avance pour une tâche spécifique, ou que les données langagières à extraire sont semi-structurées ou structurées, par exemple sous la forme de tableaux.

L’intervention humaine, onéreuse en temps et en savoir-faire, est encore nécessaire dans le pré-traitement d’informations disparates afin de les organiser en bases de données exploitables. Ces bases structurées sont essentielles pour la réalisation de tâches subséquentes en traitement automatique du langage (TAL) : la création de moteurs de recherche performants, la synthèse automatique d’articles médicaux et l’inférence automatisées d’hypothèses biomédicales découlent de ces bases de données structurées [1].

Or, une quantité constamment grandissante d’information d’intérêt, notamment en sciences de la vie, circule sur Internet [2]. Les humains ne suffisent plus à la tâche pour pré-classer cet afflux de données. Si un traitement expérimental a été développé puis publié dans une revue, mais que l’article médical ne peut être repéré par d’autres experts à l’aide d’une recherche en ligne en raison d’un manque de pré-traitement de données linguistiques, ces connaissances scientifiques seront momentanément égarées. L’innovation médicale est alors retardée par une technologie déficiente, sans parler des répercussions humaines directes.

Il devient de plus en plus pressant de permettre aux systèmes informatiques de structurer eux-mêmes les données en textes libres et de générer sans supervision humaine des bases de connaissances riches et opérationnelles pour des tâches subséquentes automatisées.

Mais comment extraire des connaissances structurées à partir de textes libres ?

C’est le défi que se propose de relever l’extraction d’information ouverte (OIE pour Open Information Extraction), ou BioOpenIE pour les sciences médicales. L’OIE dote les systèmes informatiques d’une capacité à organiser seuls des informations non-structurées en leur permettant de créer des bases de connaissances exploitables à la fois par des humains et des machines.

L’extraction d’information ouverte vise plus précisément à rendre les systèmes informatiques capables d’extirper les représentations sémantiques - dites superficielles - d’une phrase en identifiant correctement les assertions informatives. Ces assertions sont alors organisées sous la forme de triplets, ou tuples en anglais [3]. Des triplets sont composés de deux entités (A et B) correspondant à deux actants, joint par un fragment textuel contenant un verbe les reliant sémantiquement [4] :

Triplet : Entité A, relation R, Entité B

Prenons la phrase E1 en exemple pour illustrer le fonctionnement des triplets de l’OIE :

E1 : En 2021, le cancer demeure la première cause de décès au Canada.

L’objectif de l’OIE est d’extraire de manière non-supervisée des relations dites binaires telles que décrites en E2, E3 et E4. En théorie, chaque constituant d’une clause devrait se raccourcir afin de ne conserver que le contenu informatif du sens de l’énoncé d’origine.

E2 : (“le cancer”, “demeure”, “la première cause de décès”)

E3 : (“le cancer”, “demeure”, “en 2021”)

E4 : (“le cancer”, “demeure la première cause de décès”, “au Canada”)

Le système fait alors face à une double difficulté : il doit identifier avec succès ce qui est le verbe principal, et ses actants, tout en ne relevant que l’information pertinente d’une phrase [5]. De ce fait, il est attendu qu’il ne génère pas les triplets fautifs E5 et E6. Or, lorsqu’un système d’OIE est déficient, ces triplets sont aussi générés :

E5 : (“En 2021”, “demeure”, “au Canada”)

E6 : (“cancer demeure”, “cause”, “au Canada”)

La phrase E6 est représentative d’obstacles inhérents à la polysémie de la langue française : le système a en effet malencontreusement identifié le nom “cause” comme verbe plutôt que comme nom, et qu’il a aussi identifié par erreur le verbe “demeure” comme un nom.

Enfin, un système d’OIE ne doit pas non plus créer des triplets trop complexes (E7), qui les rendraient inutiles pour toutes tâches sémantiques subséquentes, notamment des inférences qui répondent à des requêtes spécifiques de recherche d’utilisateurs.

E7 : (“Le cancer”, “demeure”, “la première cause de décès au Canada en 2021”)

En plus d’une pertinence maximale de ces triplets à l’aide de stratégies d’extraction non-supervisées, l’OIE cherche à pouvoir traiter des domaines très variés de textes, autant médicaux que financiers, qui ont souvent leur vocabulaire technique unique, voire un style rédactionnel propre à leurs spécificités. Il va de soi que des phrases complexes, comme E8, représentent aussi des obstacles à une extraction d’information non-supervisée :

E8: La tomosynthèse est une méthode permettant de réaliser une tomographie sur un angle limité et à haute résolution à des niveaux de dose de rayonnement similaires à la radiographie de projection.

L’autre difficulté de l’OIE, technologique cette fois, est de réaliser de bons scores de pertinence dans un espace de temps limité, puisqu’on attend des moteurs de recherche qu’ils soient aussi rapides que performants [v. notamment 6].

Les approches d’extraction d’information ouverte

Plusieurs approches aux méthodes et aux algorithmes variées sont expérimentées en langue anglaise pour maximiser une extraction efficace et appropriée de triplets : des exemples de systèmes existants d’OIE ont été classés dans le Tableau A. Chacune de ces approches d’OIE repose sur des types d’extraction différents et des analyses syntaxiques distinctes [7] : elles génèrent des résultats de triplets différents, même si parfois l'on y retrouve des similarités dans leurs triplets, exacts comme fautifs. Tous recherchent la méthode la plus précise pour extraire des connaissances structurées à partir de texte non-structuré.

| Analyses syntaxiques | Types d’extraction | Types d’extraction |

|---|---|---|

| Données d’apprentissage (“Machine Learning Classifiers”) | À base de règles établies (“Hand-Crafted Rules”) | |

| De surface (ex. L’étiquetage grammatical ou “POS tagging”) | TextRunner WOE Pos | ReVerb R2A2 LSOE ExtrHech |

| En dépendance ou “Dependency Parsing” | WOE Parse OLLIE | ClauseIE CSD-IE DepOE |

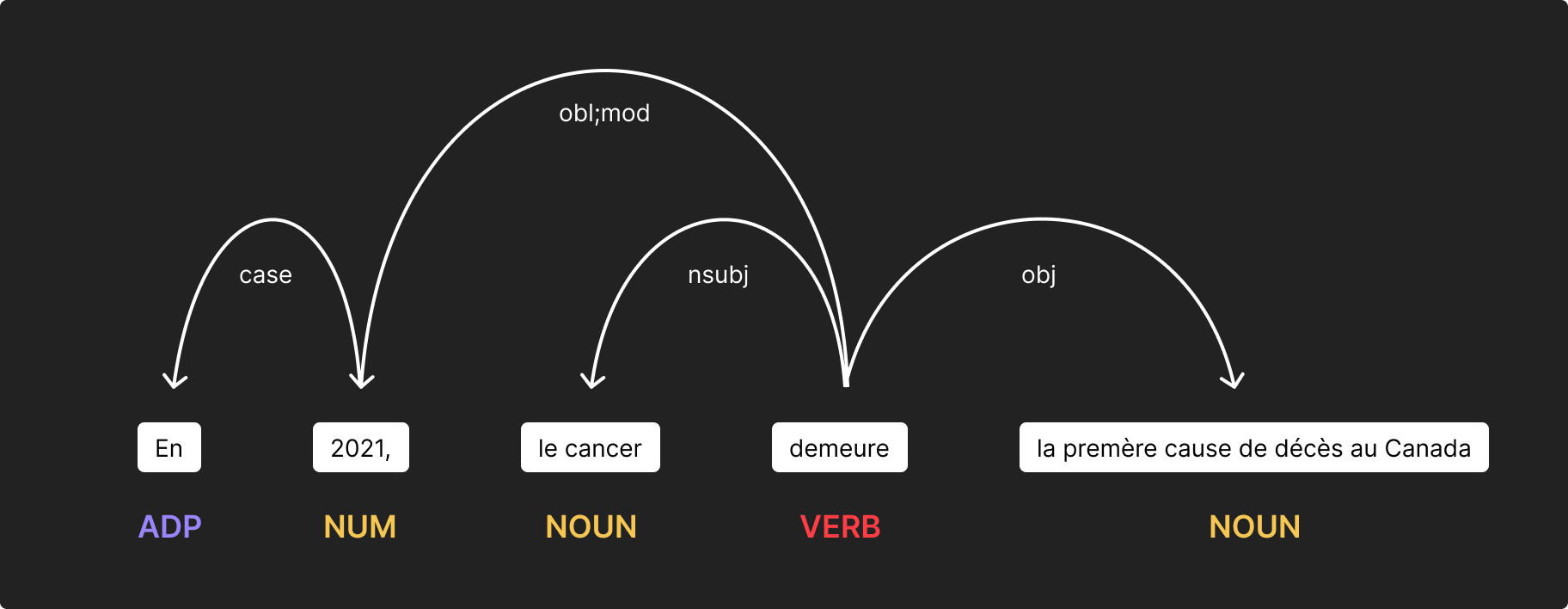

Prenons en exemple le système OLLIE (pour Open Language Learning for Information Extraction) [8] qui utilise une approche d'analyse syntaxique en dépendance afin de catégoriser de manière automatisée la structure grammaticale d’une phrase. Le système informatique recherche seul les relations entre les mots et les syntagmes pour ainsi leur octroyer des arbres de dépendances. Dans la Figure 1, le sujet (nsubj), “le cancer”, est identifié, de même que l’objet (obj) “la première cause de décès au Canada” et le complément (obl:mod).

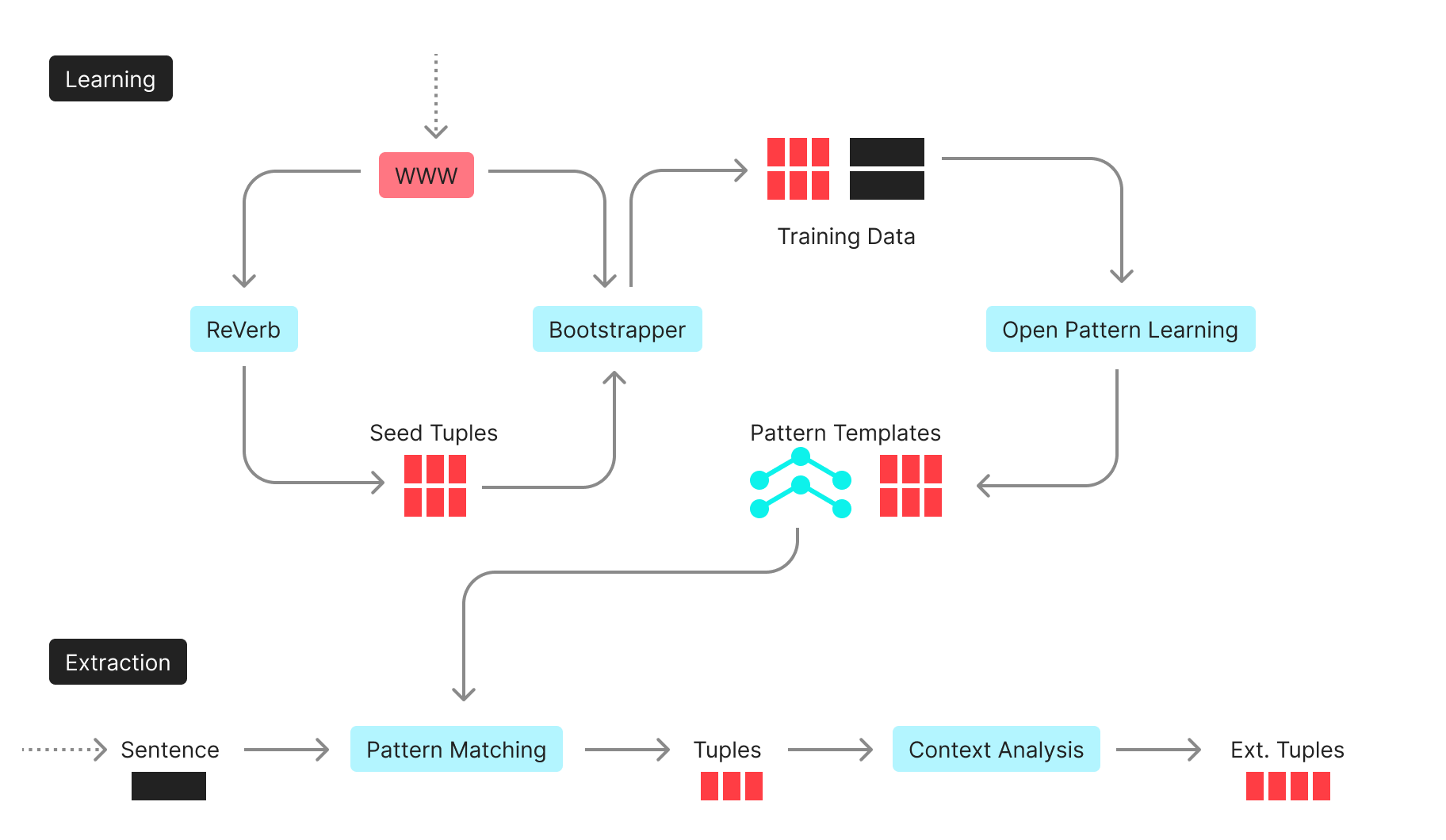

OLLIE est aussi construit sur de larges données d’apprentissage qui lui permet de faire de l’extraction ouverte d’information en se basant sur une large sélection d’exemples semblables de triplets, notamment ceux d’un autre système d’OIE, ReVerb. L’architecture complète d’OLLIE est illustrée en Figure II.

Tiré de Mausam et al., 2012

Chaque phrase analysée parcourt l’ensemble des étapes listées : on observe que les données d’entraînement participent directement aux extractions successives et révisées des triplets, qui sont aussi replacés dans leur contexte en dernière instance (“Context Analysis”). Les assertions informatives de la phrase sont alors prêtes à être interprétées au sein d’utilisations concrètes TAL.

Qu'en est-il des systèmes d’OIE en français ?

Bien que les relations logiques d'OIE ne soient pas propres à une seule langue, et que la langue anglaise partage de nombreuses similarités syntaxiques et sémantiques avec le français, appliquer directement une approche d’extraction anglo-centrique à un corpus francophone simplifierait excessivement les informations extraites. La langue française nécessiterait en théorie une méthodologie et des outils qui soient dédiés à ses spécificités métalinguistiques. Néanmoins, une modification partielle des systèmes existants d’OIE semblerait en pratique suffisante pour obtenir des extractions acceptables, quoiqu’elles soient loin d’être optimales.

Gotti et Langlais (2016), qui ont partiellement altéré le système ReVerb pour l’adapter au français, soulignent entre autres qu’un traitement particulier des clitiques (ex.: “ils s’y sont revus”, où “ils”, “s’” et “y” sont des clitiques) et des phrases sans nom ou déterminant (ex. :“Je suis partie”) fût une étape essentielle dans le pré-traitement de leurs données. Les phrases contenant des anaphores pronominales (ex. : Je l’ai fait manger) ont entre autres représenté une source d’erreur dans l’extraction de leurs triplets [9]. Dans une adaptation d’un système d’OIE anglophone pour le français, un travail en amont reste aussi indispensable pour préparer adéquatement les données linguistiques, notamment à l’aide de modèles statistiques propres à la langue qui permettent de segmenter les unités d’une phrase (“tokenization”) et étiqueter sa grammaire ou sa morphosyntaxe (“part-of-speech tagging”).

Les recherches en langue française sur ces systèmes informatiques restent encore rares. Or, au Canada comme dans d'autres pays francophones, l’industrie de la santé et des sciences de la vie repose sur des données en français qu’il faut pouvoir traiter efficacement, entre autres à l’aide de cette nouvelle technologie.

Le département de recherche de GenAiz travaille activement à l’élaboration d’un outil inédit d’extraction d’information ouverte en français pour répondre aux besoins des entreprises et des individus d’ici. Que ce soit pour l’analyse automatisée d'une autoévaluation médicale rédigée en français dans le dossier d’un patient ontarien ou le transfert de connaissances scientifiques entre des chercheurs québécois et néo-brunswickois, il est essentiel de concevoir des systèmes d’OIE spécifiques au français et de développer des algorithmes d’OIE bilingues anglais/français.

Une vision multilingue de l’OIE permettrait ultimement de dépasser les frontières linguistiques de la recherche pour une collaboration unifiée et réellement internationale des sciences de la vie.

Références

[2] Cohen KB and Hunter L. Getting started in text mining. PLoS computational biology. 4. 1. 2008.

[3] Gamallo, P. An overview of open information extraction. OpenAccess Series in Informatics. 38. 2014. 13-16.

[4] Wu F and Weld D. Open information extraction using Wikipedia. Proceedings of the 48th Annual Meeting of the Association for Computational Linguistics. 2010.

[5] Fader A, Soderland S, Etzioni O. Identifying Relations for Open Information Extraction. EMNLP 2011 - Conference on Empirical Methods in Natural Language Processing, Proceedings of the Conference. 2011:1535-1545.

[6] Banko M, Cafarella MJ, Soderland S., Broadhead M., Etzioni O. Open Information Extraction from the Web. Proceedings of the 20th International Joint Conference on Artificial Intelligence. 2007:2670–2676.

[7] Niklaus C, Cetto M, Freitas A, Handschuh S. A Survey on Open Information Extraction.Proceedings of the 27th International Conference on Computational Linguistics. 2018:3866-3878.

[8] Mausam MS et al. Open Language Learning for Information Extraction.Proceedings of the 2012 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning. 2012:523-534.

[9] Gotti F, Langlais P. Harnessing Open Information Extraction for Entity Classification in a French Corpus. Canadian AI 2016. Victoria, 2016.